Kategorie: Informationstechnologie

-

Proxmox Backup mit Veeam

In diesem Blog Beitrag schildere ich Euch meine ersten Erfahrungen mit der gerade neu erschienene Feature “Proxmox Backup mit Veeam”. Dieses tolle Feature ist seit dem 28.08.2024 brandneu und mit der Version 12.2 von Veeam erschienen. Da ich selber sehr viele Proxmox Server verantworte, habe ich mir dieses Feature gleich mal näher angesehen. Inhaltsverzeichnis Meine…

-

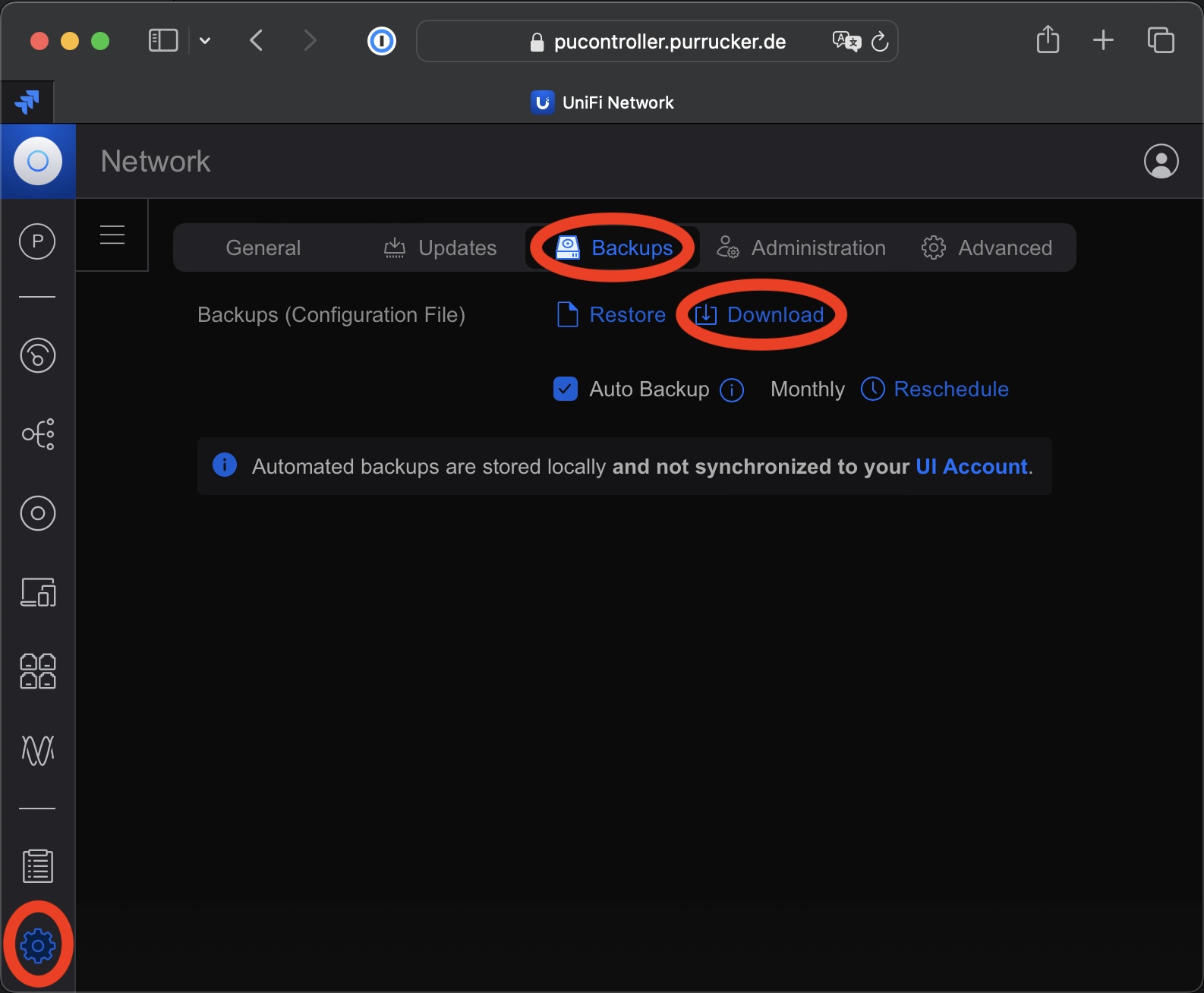

Update einer MongoDB von 3.6 auf 4.4 bei einer UniFi Network Application

Seit Ende letzten Jahres unterstützt die UniFi Network Application von Ubiquiti endlich eine MongoDB die neuer ist als die Version 3.6. Jetzt kann man immerhin die Version 4.4 einsetzen. Somit ist ein Update einer MongoDB von 3.6 auf 4.4 möglich, wenn man eine entsprechende Installation der UniFi Network Application von Ubiquiti betriebt. Diese gestaltete sich…

-

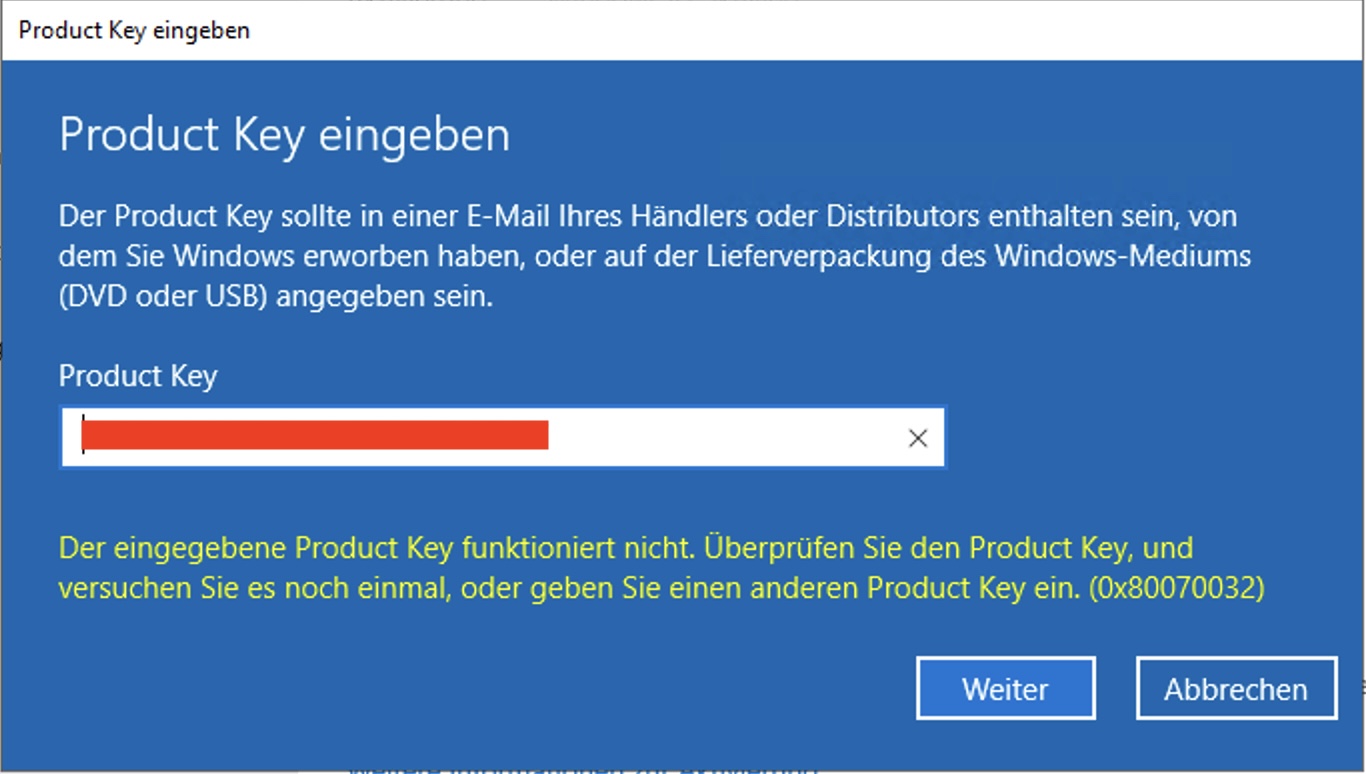

Windows Server aktivieren

Viele Admins werden es kennen. Man möchte einen Windows Server aktivieren und man bekommt die Fehlermeldung (0x80070032): “Der eingegebene Product Key funktioniert nicht”. Was kann man in solchen Fällen machen? Zumindest bei mir hat diese Fehlermeldung bei einem Windows Server 2022 bedeutet, dass die installierte Server Version nicht zum Windows Server aktivieren passt. Das nicht…

-

Microsoft Teams 2.0 ist da

Microsoft hat die von vielen Firmen verwendete Software Microsoft Teams 2.0 freigegeben. Diese kann ab sofort runtergeladen und verwendet werden. In den nächsten Tagen soll die Software schrittweise an die Benutzer ausgerollt werden. Dazu soll in der Titelleiste des Clients eine Nachricht eingeblendet werden, über welche die Benutzer zu der neuen Version wechseln können. In…

-

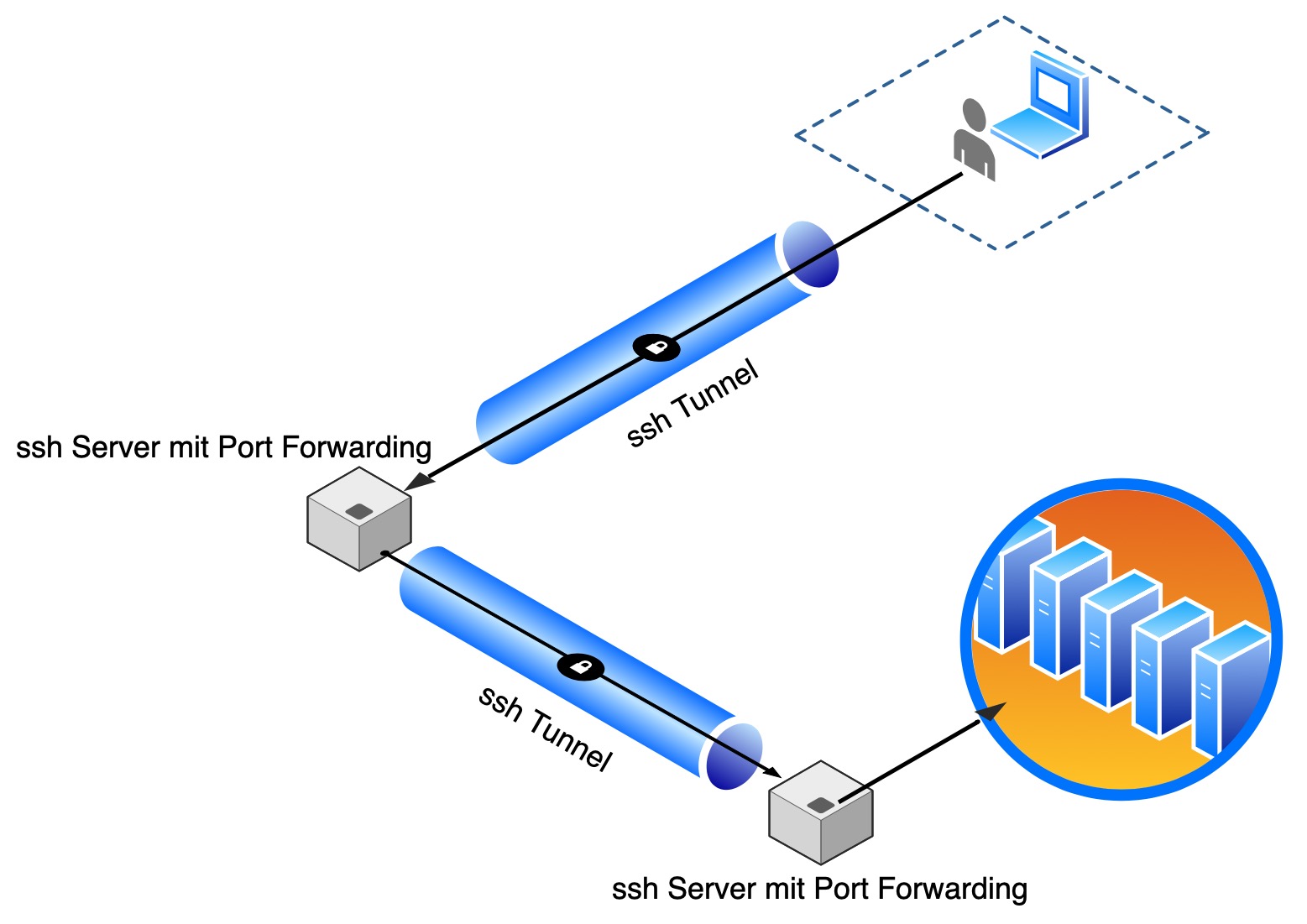

Port Forwarding mit ssh

Port Forwarding mit OpenSSH ist eine sichere und flexible Methode, um auf entfernte Dienste zuzugreifen und Datenverkehr zwischen dem lokalen Rechner und einem entfernten Server sicher und verschlüsselt zu transportieren. Dies ist besonders nützlich für Systemadministratoren, Entwickler und alle, die oft sichere Verbindungen zu entfernten Servern herstellen müssen. Einfacher als das Port Forwarding mit ssh…

-

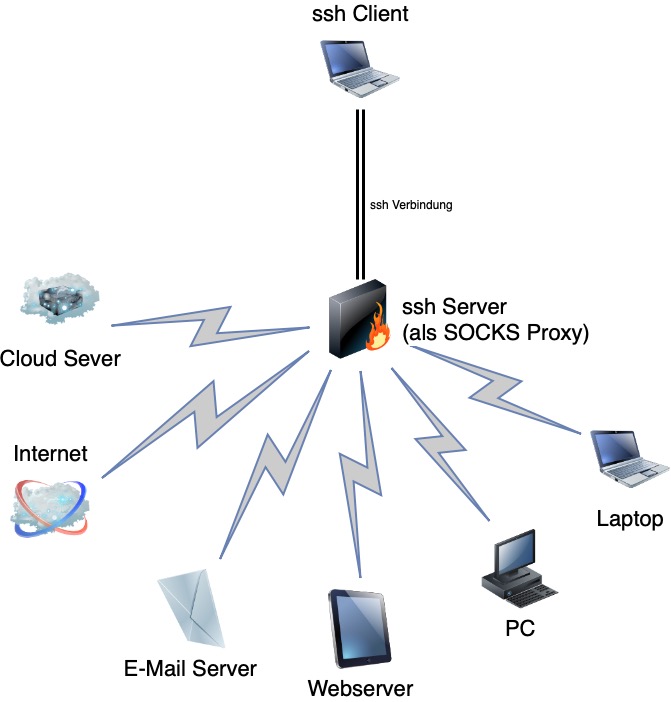

ssh als SOCKS Proxy

Durch die Möglichkeit ssh als SOCKS Proxy zu verwenden ist es möglich Verbindungen durch eine ssh-Verbindung zu Tunneln. Dadurch kann man auf Geräte zugreifen, die sich in Netzen befinden, auf welche kein direkter Zugriff besteht. Es reicht aus sich mit einem Gerät per ssh zu verbinden, welches Zugriff auf das gewünschte Zielsystem hat. Anschließen wird…

-

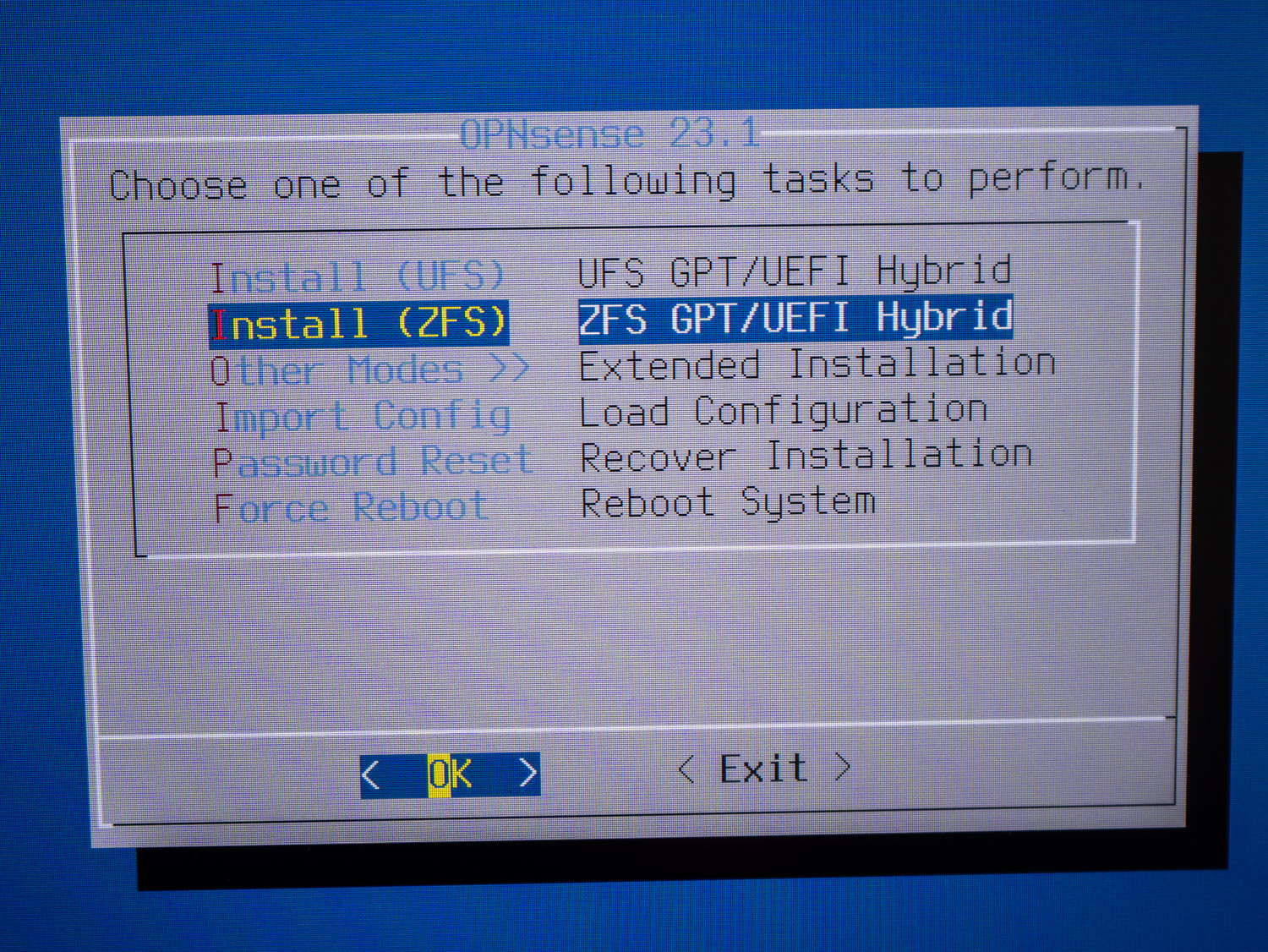

OPNsense mit ZFS

Seit der Version 21.1 von OPNsense, die im Januar 2021 veröffentlicht wurde, kann man optional für die Installation von OPNsense mit ZFS (Zettabyte File System) durchführen. Die Benutzer haben seit dem die Möglichkeit, während der Installation das bevorzugte Dateisystem auszuwählen. Dabei kann man sich für ZFS entscheiden. Dadurch wird der Datenträger nicht mit dem alten…

-

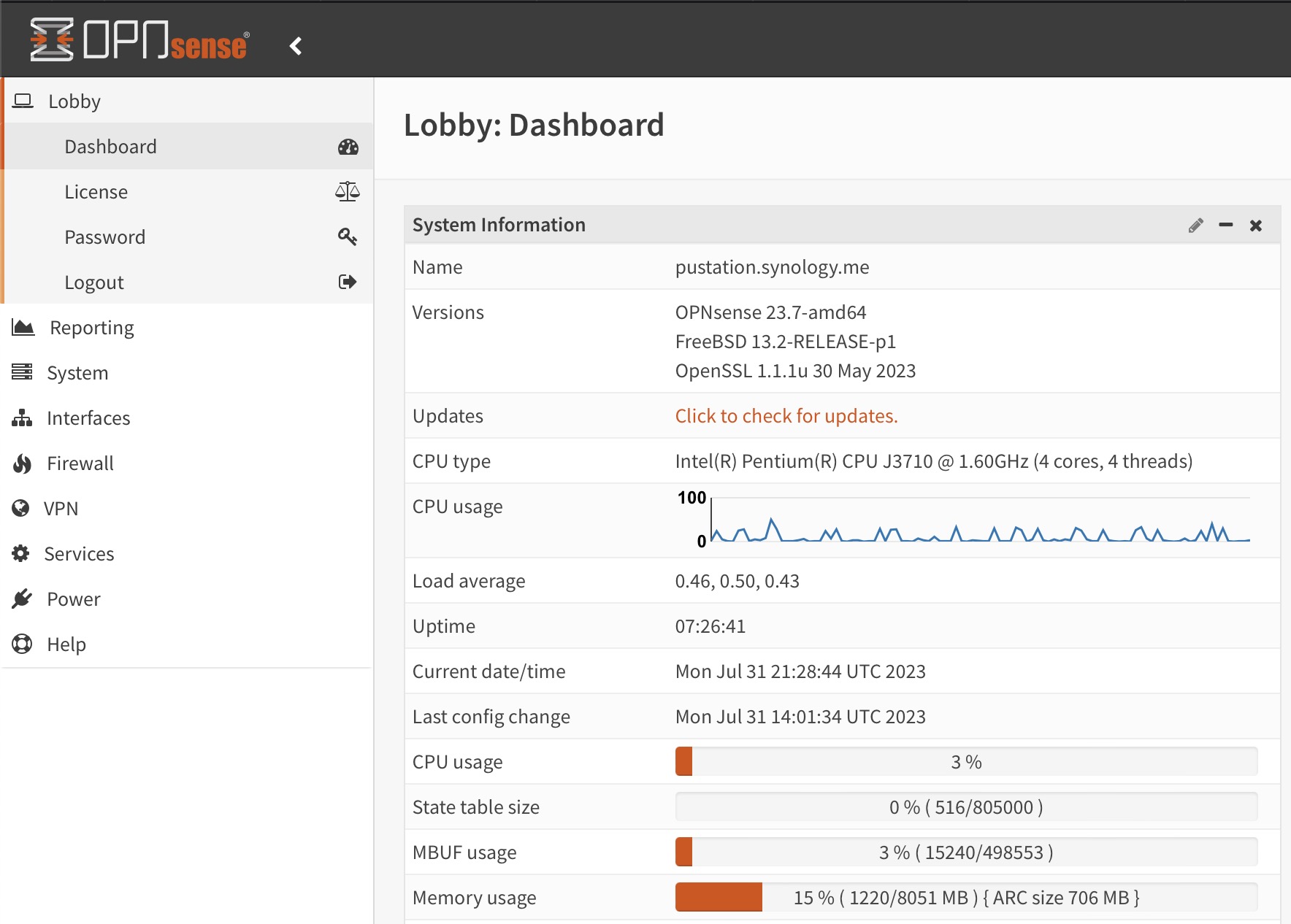

OPNsense 23.7 mit neuem OpenVPN und IPSec

Die Entwickler der Opensource Firewall OPNsense haben heute pünktlich und wie angekündigt die neue Major Community Version OPNsense 23.7 mit dem Nickname “Restless Roadrunner” veröffentlicht. Majorupdates für die Community Version erscheinen jeweils halbjährlich. Was ist neu bei OPNsense 23.7 Wie fleissig die Entwicklung der Firewall voranschreitet, kann man an den 88 Verbesserungen und Updates sehen,…

-

Upgrade auf Debian 12 Bookworm

Am 10. Juni 2023 wurde Debian 12 Bookworm veröffentlicht. Dieser Artikel erläutert kurz, was zu tun ist, um ein Upgrade von Debian 11 Bullseye auf Debian 12 Bookworm bei einer bestehenden Installation durchzuführen. Im Prinzip ist das vorgehen dabei seit Jahren gleich. Schon bei dem Upgrade von Version 6.0 (Squeeze) auf Version 7.0 (Wheezy) war das Vorgehen nahezu identisch.…

-

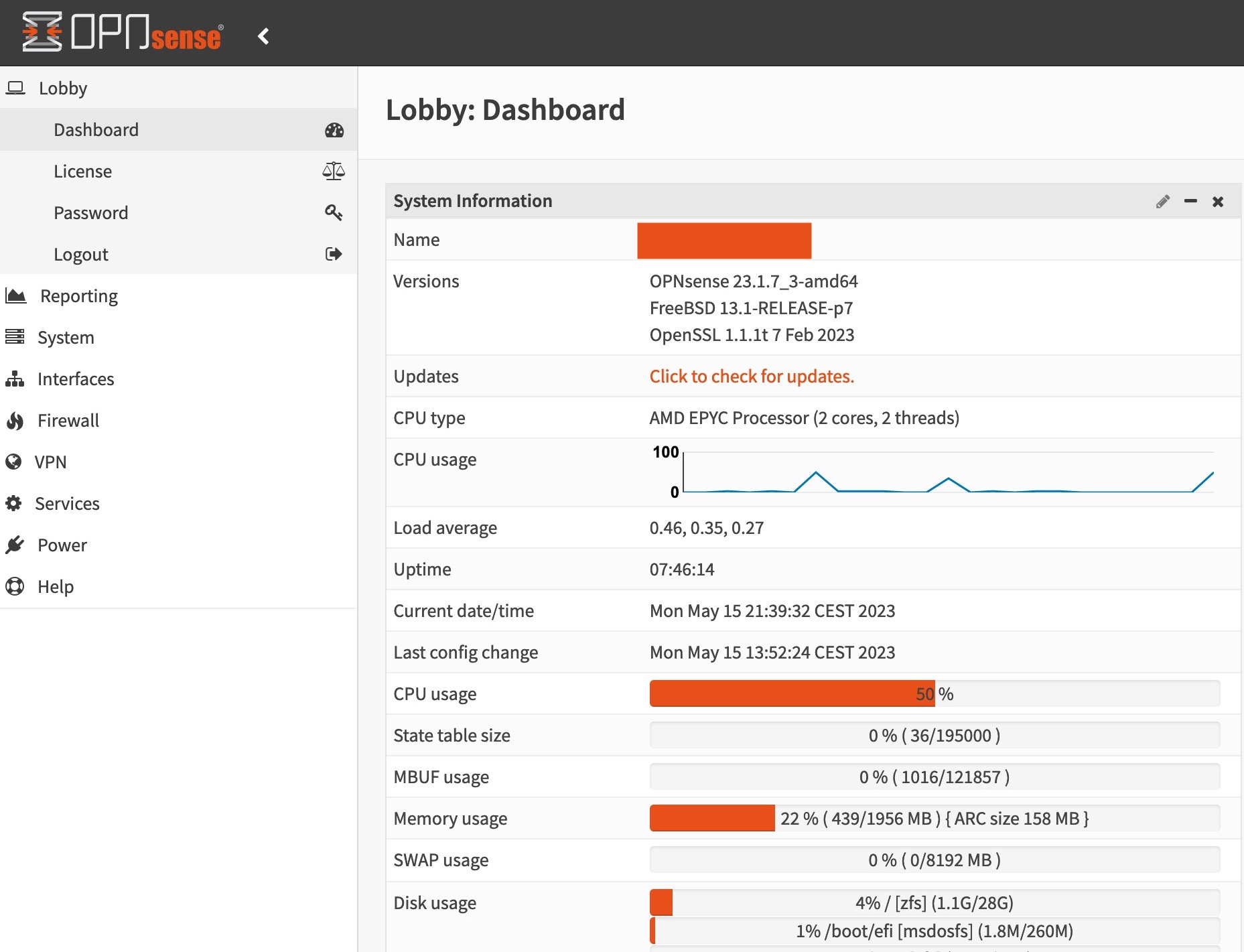

Hohe CPU-Auslastung durch Zufallszahlen bei OPNsense

Auffälligkeiten bei der CPU-Auslastung Durch Auffälligkeiten auf einer meiner OPNsense Firewalls in der Cloud bei Hetzner, habe ich eine zu hohe CPU-Auslastung durch Zufallszahlen bei OPNsense in der Version 23.1.6 entdeckt. Dabei lastet der für die Erzeugung der Zufallszahlen zuständige Systemprozess rand_harvestq einen CPU Kern komplett aus. Eine Recherche im Internet zeigte mir, dass Ich…