-

Reha: Mein Weg zurück mit neuer Hüfte

High-Tech, Herzlichkeit und der weite Weg zurück Fünf Wochen sind vergangen, seit ich in der VITREA Ostseeklinik Damp meine neue Hüft-Endoprothese erhalten habe. Wer meinen Blog Artikel „Mein Weg zur neuen Hüfte (TEP) mit 51“ gelesen hat, weiß: Mit 51 Jahren ist das Ziel klar – ich will so schnell wie möglich zurück in ein aktives Leben.…

-

Warum meine neue Hüfte einen Masterplan für Sneaker brauchte

Die Operation ist überstanden, die neue Endoprothese der Hüfte (TEP) sitzt – und nachdem ich mir schon Gedanken über die richtige Rehaklinik oder das Essen im Krankenhaus gemacht habe, hat mich ein ganz anderes Thema gepackt. Man könnte es „Reha-Vorbereitung“ oder „Masterplan für Sneaker“ nennen, aber wer mich kennt, weiß: Es ist nicht nur mein…

-

Mein Weg zur neuen Hüfte (TEP) mit 51

Endlich schmerzfrei: Ein Abschied vom Morbus Perthes und ein technisches Meisterwerk in Damp Es ist ein seltsames Gefühl, wenn ein Schmerz, der einen fast das ganze Leben begleitet hat, plötzlich weg ist. Einfach weg. Aber fangen wir von vorne an, denn meine Reise zu meiner neuen Hüfte (Endoprothese / TEP) begann eigentlich schon, als ich vier…

-

Roadtrip durch die Rocky Mountains in den USA | Woche 3: Rafting, Mountainbike und Denver

Im letzen Teil des Blogs „Roadtrip durch die Rocky Mountains in den USA | Woche 2: Cowboys, Arches und Monument Valley“ waren wir geflascht von den epische Ausblicke auf die Rocky Mountains, als wir vom Monument Valley kommend über Durango nach Grand Junction gefahren sind. Doch die zentralen Rocky Mountains liegen noch vor uns. Woche…

-

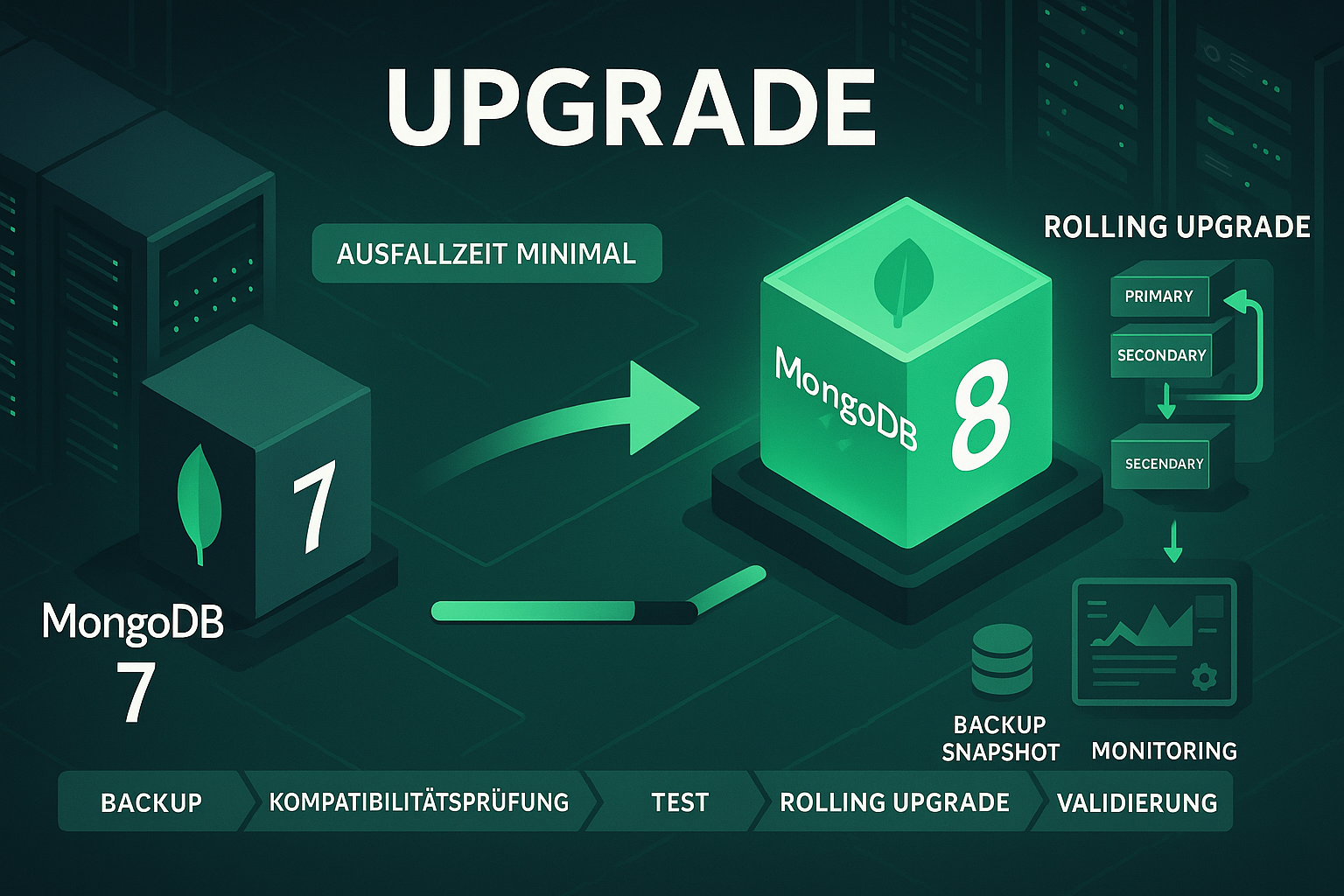

MongoDB 8 Upgrade bei Debian 13 Trixie

Es wurde Zeit, die von mir betreuten MongoDB-Instanzen von Version 7 auf Version 8 zu aktualisieren. Da ein MongoDB 8 Upgrade und die komplett umgebaute apt-Sourcen-Verwaltung bei Debian 13 Trixie eine brisante Gemengelage für ein Upgrade ergeben, habe ich diesmal besonders gründlich gearbeitet. Ich habe eine Schritt-für-Schritt-Anleitung erstellt und diese abgearbeitet. Im folgenden Blogbeitrag halte…

-

Nintendo Switch2

Als Nintendo vor einigen Wochen ankündigte, die neue Nintendo Switch2 zusammen mit einem neuen Mario Kart herauszubringen, konnte ich nicht widerstehen und musste sie gleich bestellen. Wir sind in der Familie Purrucker große Fans von Mario Kart. Mario Kart ist ein tolles Familienspiel, welches allen Altersgruppen spaß macht. Das Spiel ist zwar zeitlos – auch…

-

ALLNET ALL3419: Kosteneffiziente Temperaturüberwachung mit nahtloser Integration in CheckMK

Nach einem Ausfall einer Temperaturüberwachungslösung stand ich vor der Herausforderung, schnell eine zuverlässigen und gleichzeitig kostengünstigen Ersatz zu finden. Die Suche nach einer Alternative führte mich zu verschiedenen Lösungen am Markt, wobei besonders die ALLNET ALL3419 * durch ihr ausgewogenes Preis-Leistungs-Verhältnis hervorstach. Die Anforderungen waren klar definiert: Die neue Lösung sollte nicht nur zuverlässig sein,…

-

Roadtrip durch die Rocky Mountains in den USA | Woche 2: Cowboys, Arches und Monument Valley

Unser Roadtrip durch die Rocky Mountains geht weiter. Nachdem wir in der ersten Woche unseres Roadtrips Portland in Oregon und den Yellowstone Nationalpark erkundet haben, stehen in dennächsten Tagen Cowboys in Jackson, die Mormonen ins Salt Lake City, der Arches Nationalpark und das Monument Valley auf dem Programm. Woche 2: Richtung Süden Nachdem wir in…

-

Roadtrip durch die Rocky Mountains in den USA | Woche 1: Es geht endlich los

Ende Juli ist es endlich soweit. Wir starten zu unserem Roadtrip durch die Rocky Mountains in die USA. Am 28.08.2024 fliegen wir mit Icelandair von Hamburg nach Portland in Oregon, mit einem Zwischenstop in Reykjavik. Unser Flug ist einer der ersten in Hamburg an diesem Tag und startet um 6:45 Uhr. Wir sind deshalb schon…

-

Proxmox Backup mit Veeam

In diesem Blog Beitrag schildere ich Euch meine ersten Erfahrungen mit der gerade neu erschienene Feature „Proxmox Backup mit Veeam“. Dieses tolle Feature ist seit dem 28.08.2024 brandneu und mit der Version 12.2 von Veeam erschienen. Da ich selber sehr viele Proxmox Server verantworte, habe ich mir dieses Feature gleich mal näher angesehen. Inhaltsverzeichnis Meine…

Mikroblog bei Mastodon

- Loading Mastodon feed…