-

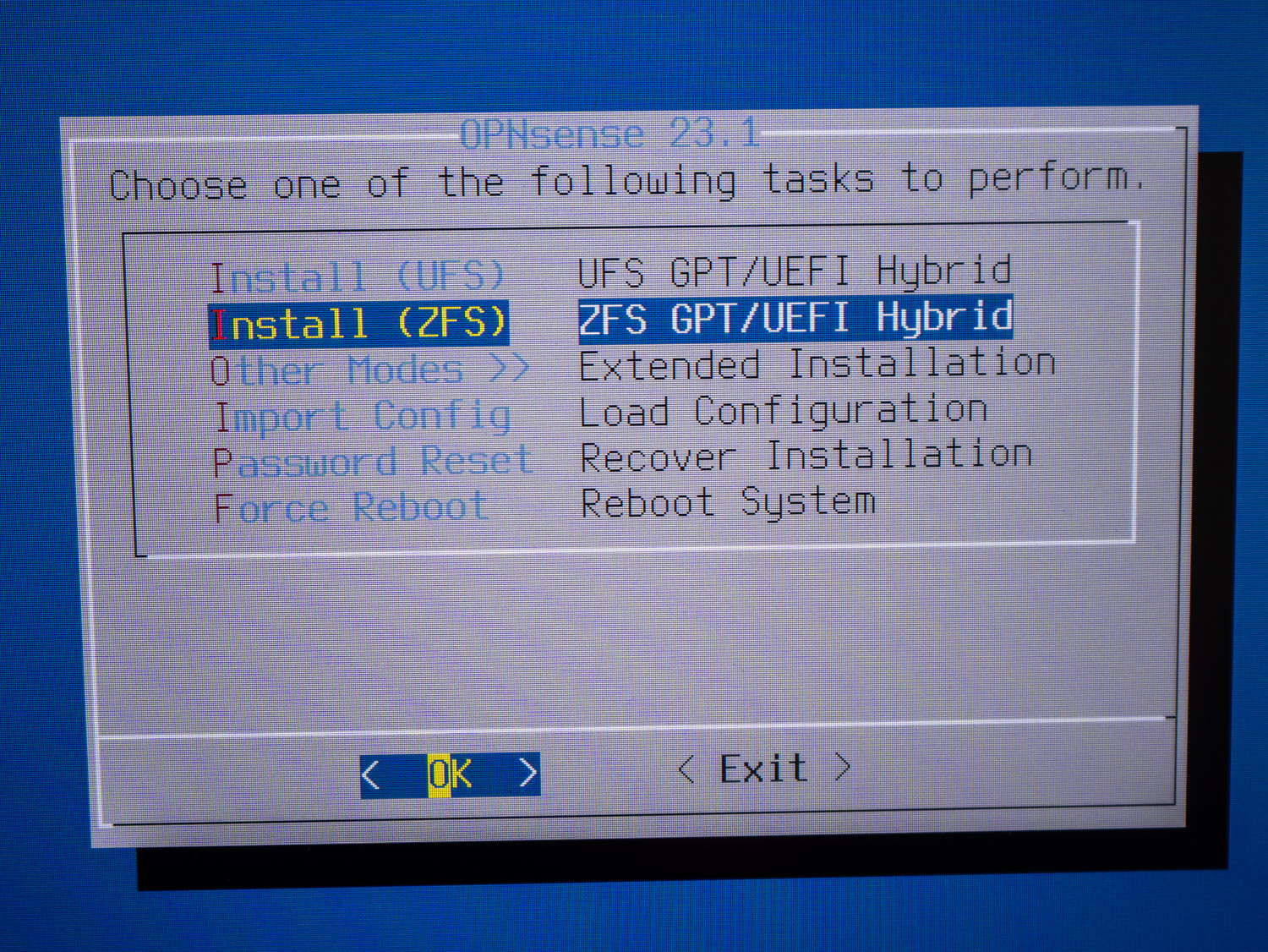

OPNsense mit ZFS

Seit der Version 21.1 von OPNsense, die im Januar 2021 veröffentlicht wurde, kann man optional für die Installation von OPNsense mit ZFS (Zettabyte File System) durchführen. Die Benutzer haben seit dem die Möglichkeit, während der Installation das bevorzugte Dateisystem auszuwählen. Dabei kann man sich für ZFS entscheiden. Dadurch wird der Datenträger nicht mit dem alten…

-

Im wilden Westen der USA | Teil 8: Bryce Canyon and Grand Canyon

Heute geht es mit dem neuen roten Auto Richtung Bryce Canyon and Grand Canyon, nachdem uns das blaue Auto aufgebrochen wurde und wir dieses in Las Vegas tauschen mussten. Wie das genau passiert ist kann im Blog Beitrag Im wilden Westen der USA | Teil 7: Las Vegas nachgelesen werden. Fahrt nach Hutch zum Bryce…

-

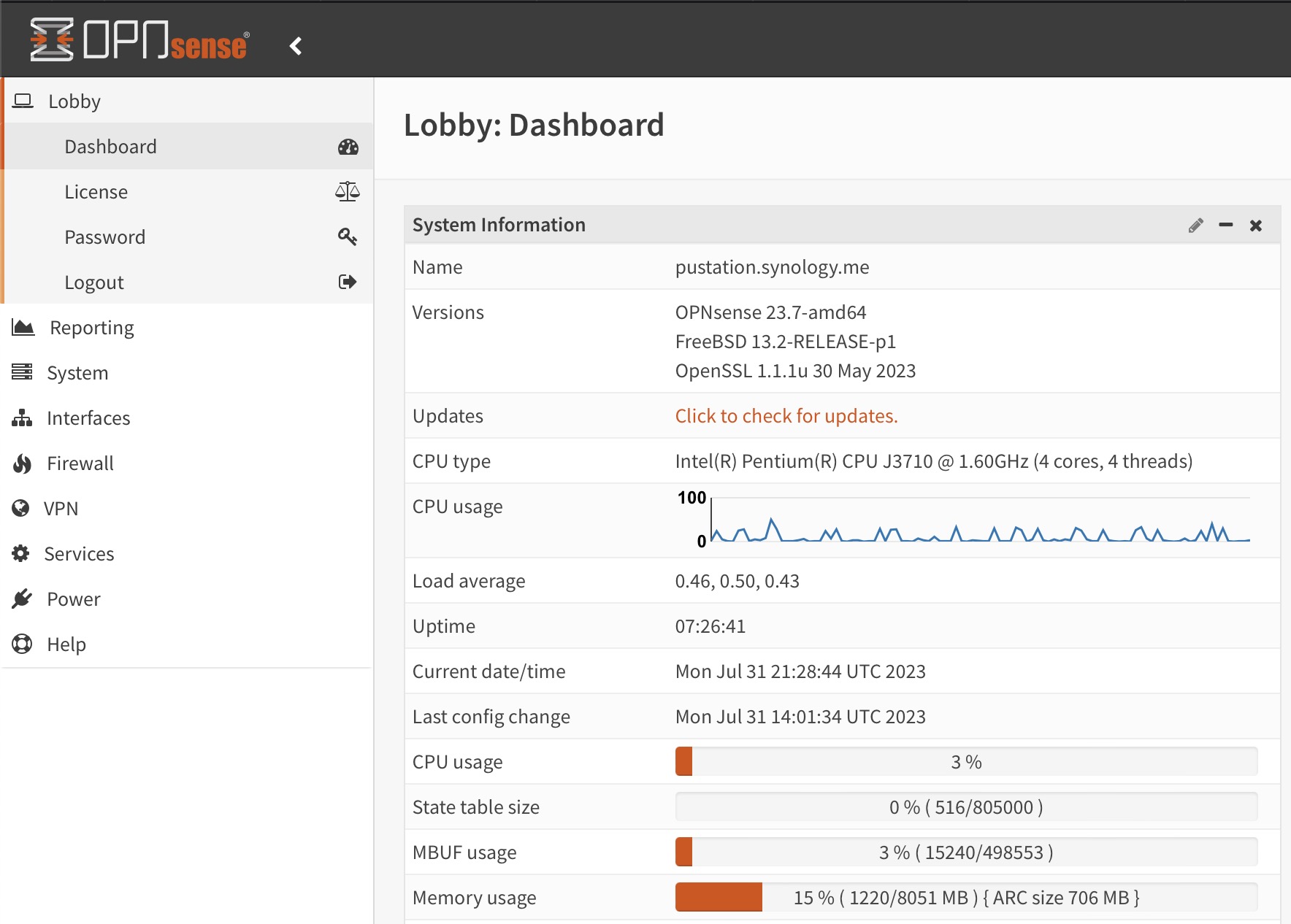

OPNsense 23.7 mit neuem OpenVPN und IPSec

Die Entwickler der Opensource Firewall OPNsense haben heute pünktlich und wie angekündigt die neue Major Community Version OPNsense 23.7 mit dem Nickname “Restless Roadrunner” veröffentlicht. Majorupdates für die Community Version erscheinen jeweils halbjährlich. Was ist neu bei OPNsense 23.7 Wie fleissig die Entwicklung der Firewall voranschreitet, kann man an den 88 Verbesserungen und Updates sehen,…

-

Im wilden Westen der USA | Teil 7: Las Vegas

Heute geht es weiter nach Las Vegas. Wir haben nach der abenteuerlichen Springflut im Death Valley am Vortag erst mal ausgeschlafen (nachzulesen im Blogbeitrag Im wilden Westen der USA | Teil 6: Springflut im Death Valley) und bevor wir starten gönnen wir uns ein deftiges, amerikanisches Frühstück mit Panncakes, Speck, Rührei und Fleisch. Sogar Hamburger…

-

Upgrade auf Debian 12 Bookworm

Am 10. Juni 2023 wurde Debian 12 Bookworm veröffentlicht. Dieser Artikel erläutert kurz, was zu tun ist, um ein Upgrade von Debian 11 Bullseye auf Debian 12 Bookworm bei einer bestehenden Installation durchzuführen. Im Prinzip ist das vorgehen dabei seit Jahren gleich. Schon bei dem Upgrade von Version 6.0 (Squeeze) auf Version 7.0 (Wheezy) war das Vorgehen nahezu identisch.…

-

Im wilden Westen der USA | Teil 6: Springflut im Death Valley

Nach dem Yosemite Nationalpark (nachzulesen im Blogbeitrag Im wilden Westen der USA | Teil 5: Die Berge im Yosemite Nationalpark) steht heute eine Fahrt durch das Death Valley auf dem Programm. Wir ahnen beim Start noch nicht, dass an diesem Tag die zweitgrößte jemals gemessene Regenmenge runtergehen und eine Springflut im Death Valley verursachen wird. Wer konnte…

-

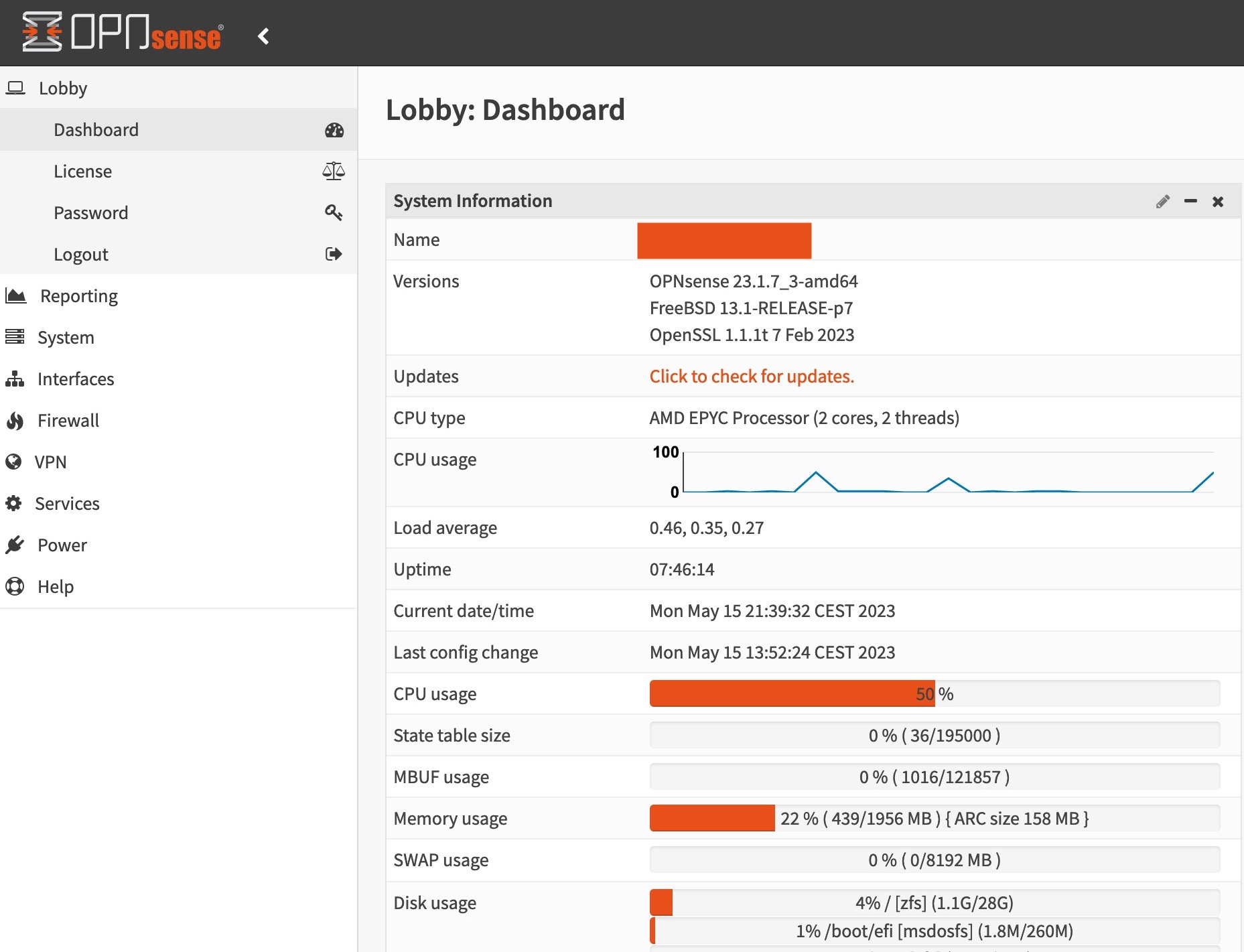

Hohe CPU-Auslastung durch Zufallszahlen bei OPNsense

Auffälligkeiten bei der CPU-Auslastung Durch Auffälligkeiten auf einer meiner OPNsense Firewalls in der Cloud bei Hetzner, habe ich eine zu hohe CPU-Auslastung durch Zufallszahlen bei OPNsense in der Version 23.1.6 entdeckt. Dabei lastet der für die Erzeugung der Zufallszahlen zuständige Systemprozess rand_harvestq einen CPU Kern komplett aus. Eine Recherche im Internet zeigte mir, dass Ich…

-

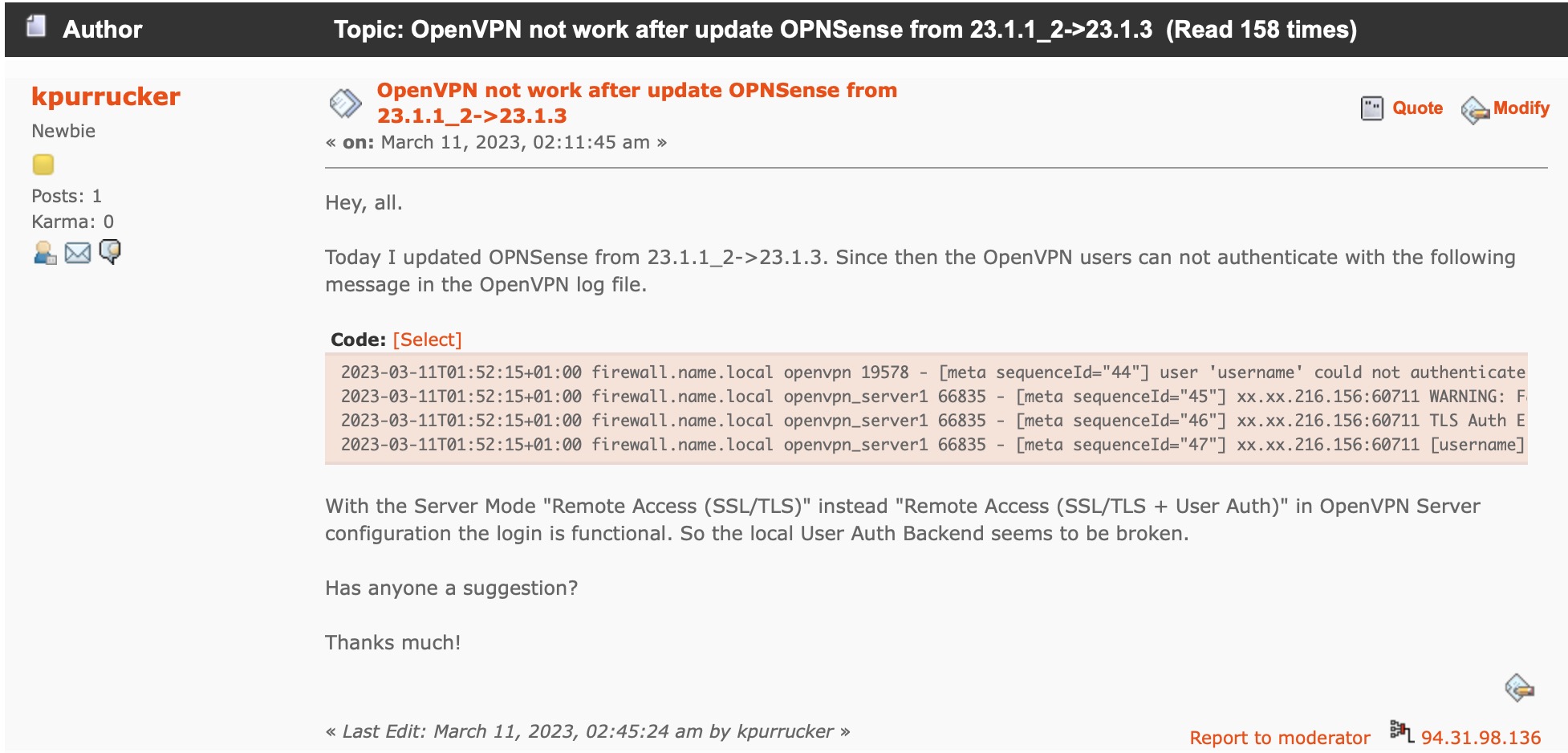

OpenVPN bei OPNsense 23.1.3 kennt keine User mehr

Eigentlich wollte ich am Freitag Abend nur noch mal schnell die Sicherheitsupdate auf allen von mir verantworteten OPNsense Firewalls einspielen. Und es war noch nicht mal Freitag der 13., sondern Freitag der 10.03.2023. Außerdem schien das kleine erschienene Update mit der Versionsnummer 23.1.3 laut Release Tag nur 6 Änderungen zu beinhalten. Doch leider dauerte das…

-

Was bringt das 10 GBit Netzwerk für die DS923+ von Synology?

Ich brauchte mal wieder einen neuen NAS (Network Attached Storage). Und ich habe mich für den brandneuen Synology DS923+ NAS mit 10 GBit Netzwerkkarte entschieden. Es ist der erste kleine NAS dieser Plus-Serie von Synology, in dem eine 10 GB Netzwerkkarte nachgerüstet werden kann. In einem kleinen Erweiterungssteckplatz auf der Rückseite kann dazu eine spezielle…

-

Kritische Sicherheitslücke in ClamAV (CVE-2023-20032)

Es gibt eine kritische Sicherheitslücke in ClamAV mit der CVE Nummer CVE-2023-20032 und alle Nutzer dieser Software sollten dringend auf eine abgesicherte Version aktualisieren. Da ClamAV in sehr vielen Softwareprodukten eingebaut ist, ist eine große Anzahl von Systemen betroffen. Bedauerlicher Weise gibt es aktuell noch nicht für alle Systeme entsprechende Updates. Da sehr viele oder…