Schlagwort: Linux

-

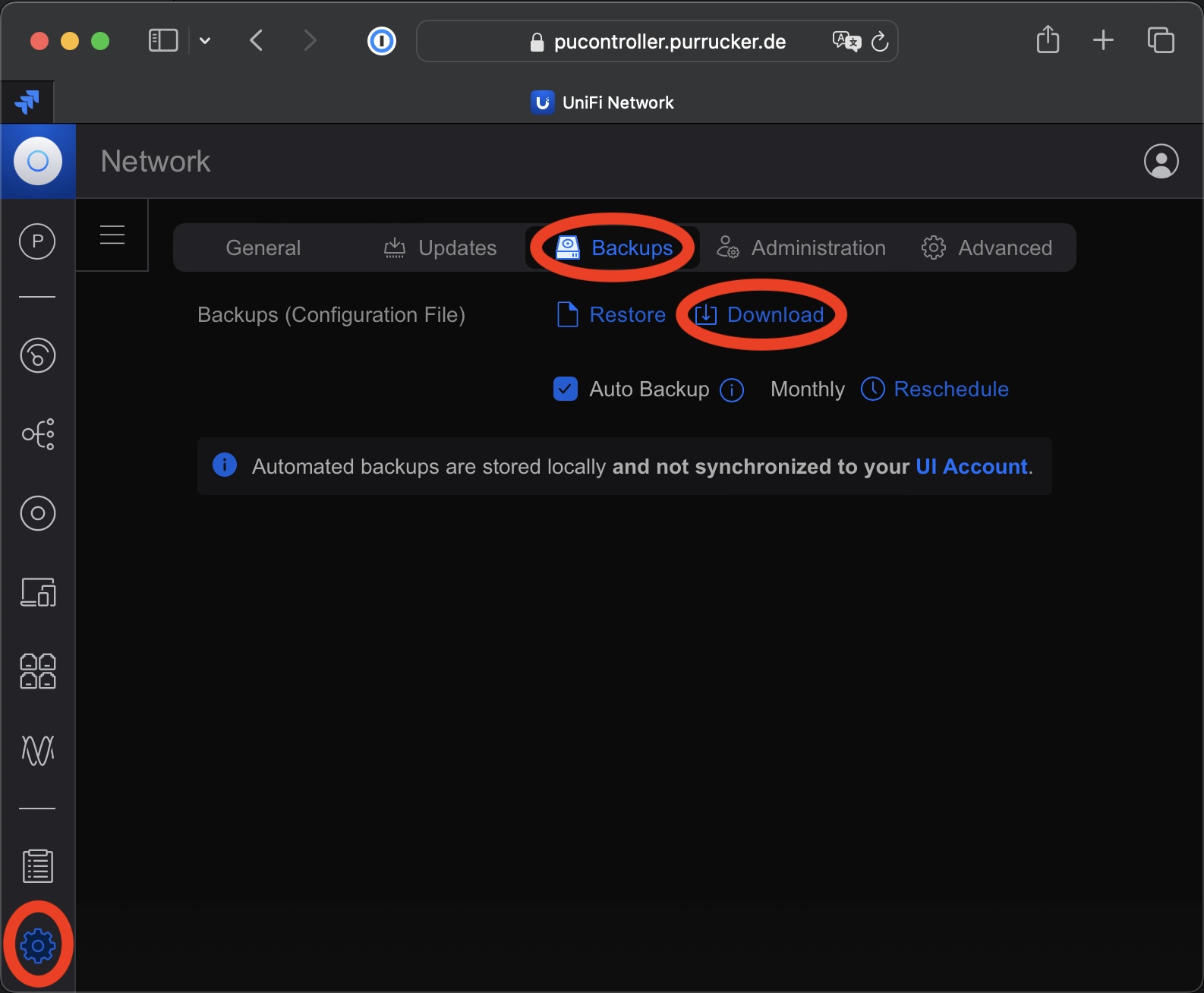

Update einer MongoDB von 3.6 auf 4.4 bei einer UniFi Network Application

Seit Ende letzten Jahres unterstützt die UniFi Network Application von Ubiquiti endlich eine MongoDB die neuer ist als die Version 3.6. Jetzt kann man immerhin die Version 4.4 einsetzen. Somit ist ein Update einer MongoDB von 3.6 auf 4.4 möglich, wenn man eine entsprechende Installation der UniFi Network Application von Ubiquiti betriebt. Diese gestaltete sich…

-

Upgrade auf Debian 12 Bookworm

Am 10. Juni 2023 wurde Debian 12 Bookworm veröffentlicht. Dieser Artikel erläutert kurz, was zu tun ist, um ein Upgrade von Debian 11 Bullseye auf Debian 12 Bookworm bei einer bestehenden Installation durchzuführen. Im Prinzip ist das vorgehen dabei seit Jahren gleich. Schon bei dem Upgrade von Version 6.0 (Squeeze) auf Version 7.0 (Wheezy) war das Vorgehen nahezu identisch.…

-

Kritische Sicherheitslücke in ClamAV (CVE-2023-20032)

Es gibt eine kritische Sicherheitslücke in ClamAV mit der CVE Nummer CVE-2023-20032 und alle Nutzer dieser Software sollten dringend auf eine abgesicherte Version aktualisieren. Da ClamAV in sehr vielen Softwareprodukten eingebaut ist, ist eine große Anzahl von Systemen betroffen. Bedauerlicher Weise gibt es aktuell noch nicht für alle Systeme entsprechende Updates. Da sehr viele oder…

-

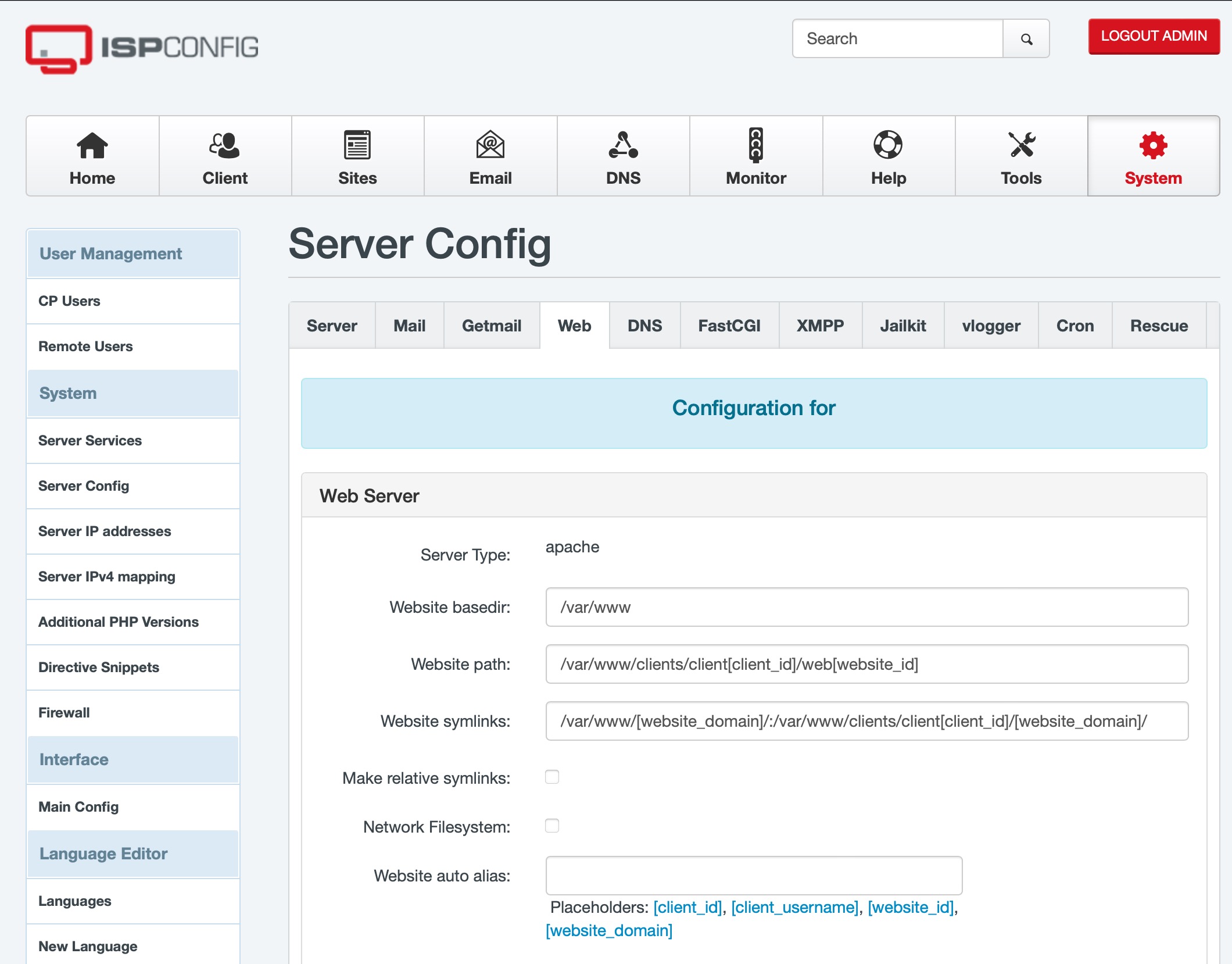

Update eines ISPConfig Perfect Server von Ubuntu 20.04 auf Ubuntu 22.04

Endlich ist das Update eines ISPConfig von Ubuntu 20.04 auf Ubuntu 22.04 möglich! Lange hat es gedauert, aber ab der am 21. November 2022 veröffentlichten Version 3.2.9 unterstützt ISPConfig endlich Ubuntu 22.04. Zumindest, wen man mailman nicht verwendet, welches bei Ubuntu 22.04 nur noch in der von ISPConfig noch nicht unterstützten Version 3 enthalten ist.…

-

Sicherheitslücke Log4Shell CVE-2021-44228

Vor einer Woche hat das BSI zum ersten mal die Warnstufe Rot ausgerufen. Durch die Sicherheitslücke Log4Shell CVE-2021-44228 im weit verbreiteten Framework Log4J sind potenziell fast alle Java-Anwendungen angreifbar. Log4J ist der De-facto-Standard für das Loggen von Java-Anwendungen. Deshalb sind weltweit sehr viele Anwendungen betroffen. Für mich bedeutete die Sicherheitslücke jetzt erst mal eine anstrengende…

-

Debian: Upgrade von 10 (Buster) auf 11 (Bullseye)

Am 14. August 2021 wurde Debian 11 (Bullseye) veröffentlicht. Dieser Artikel erläutert kurz, was zu tun ist, um ein Upgrade von Version 10 (Buster) auf Version 11 (Bullseye) bei einer bestehenden Installation durchzuführen. Im Prinzip ist das vorgehen dabei seit Jahren gleich. Schon bei dem Upgrade von Version 6.0 (Squeeze) auf Version 7.0 (Wheezy) war…

-

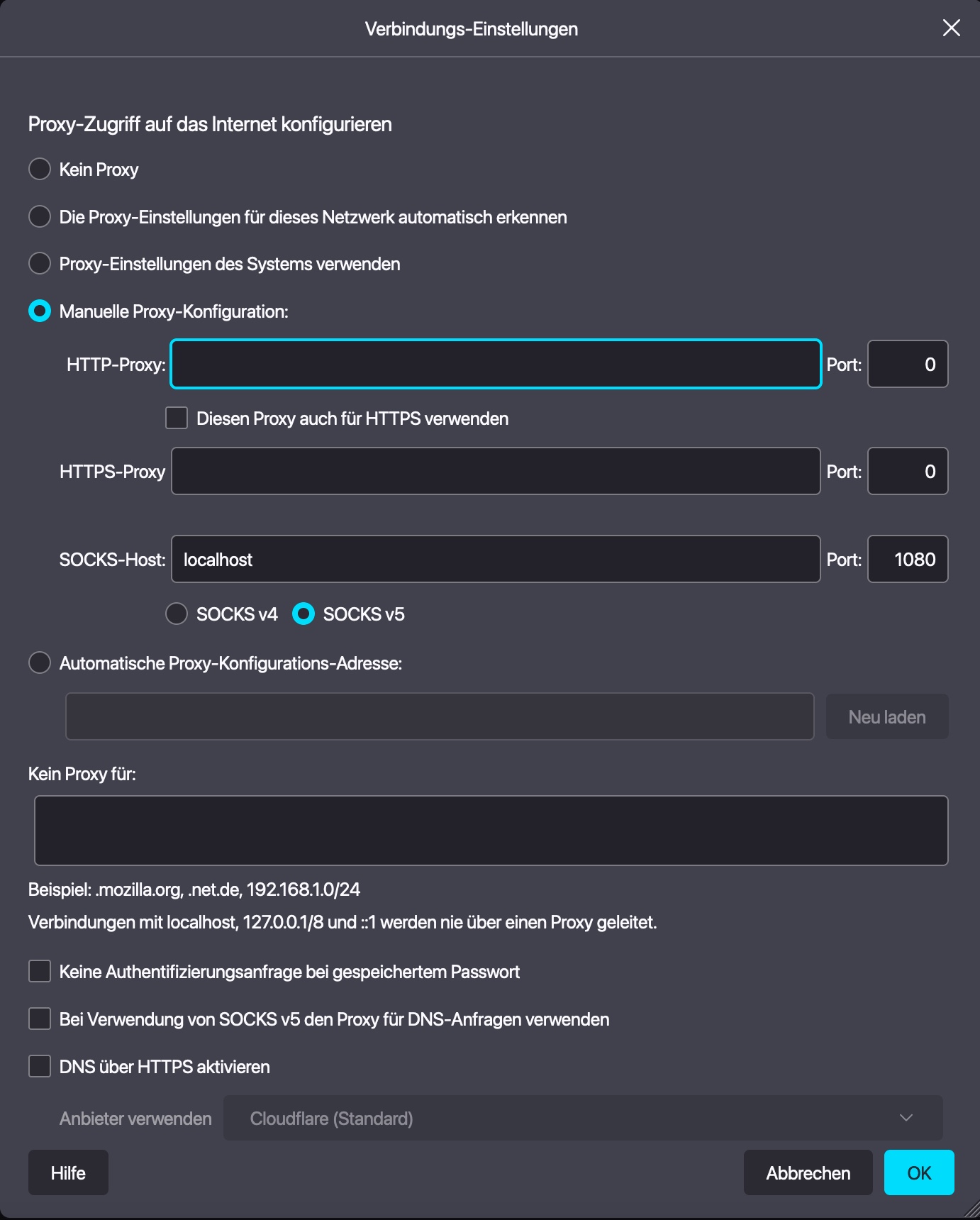

ssh als SOCKS-Proxy verwenden

Eine geniale Funktion des ssh Protokolls ist der SOCKS-Proxy. Viele kennen und nutzen diese gar nicht. Dabei hilft einem diese enorm bei der Administration von Servern. Ich nutze diese Funktion z.B. sehr häufig, um mit einem Webbrowser aus einem andern Netzwerk zuzugreifen. Dies ist sehr praktisch, wenn man mit seinem Notebook gerade in einem andern…

-

Einbinden einer neuen Festplatte bei Linux zur Laufzeit

In Zeiten zunehmender Virtualisierung (mit VMware vSphere, KVM, Citrix usw.) wird es immer häufiger notwendig Festplatten im laufenden Betrieb einzubinden, da diese ohne Neustart einfach zu einer virtuellen Maschine hinzufügen wurden. Bei Linux tauchen diese Platten ohne Neustart des Gastes aber nicht so einfach auf. Damit man diese auch im laufenden Betrieb zu Gesicht bekommt,…

-

Achtung: Fehlfunktion durch ablaufende Sicherheitszertifikate bei den Dell OS10 Switches

Dell hat gerade seine Kunden gerade per E-Mail angeschrieben und vor einem besonders heimtückischen Problem bei den OS10 Switches gewarnt. Bestimmte Versionen von OS10 (beginnend mit 10.4.1.4 bis 10.5.0.7 P3) enthalten ein Standardzertifikat, das für VLT Peer Establishment und die SFS-Cluster-Bildung verwendet wird. Und genau dieses Standardzertifikat läuft am 27. Juli 2021 ab. Dell beschreibt im…

-

Installation einer neueren PHP-Version auf einem älteren Ubuntu

Es kommt gerade bei den LTS-Versionen von Ubuntu immer häufiger vor, dass eine Software zwingend eine neuere PHP-Version voraussetzt, als auf einem Server mit einem Ubuntu Betriebssystem gerade installiert ist. Wie kann ein solche Herausforderung lösen? Eine Möglichkeit diese Anforderung zu erfüllen ist ein Upgrade des Ubuntu auf ein neues Release. Oft möchte man dies…